LLM竟然這麼靠近:使用llama模型建立大模型本機系統

活動訊息

內容簡介

LLM竟然這麼靠近 - 使用llama模型建立大模型本機系統

https://youtu.be/S7MsG6xZp6Y

✴︎ 感知機架構,包括前饋網路與反向傳播演算法

✴︎ Sigmoid、ReLU啟動函數與Adam、RMSProp最佳化方法

✴︎ Transformer模型組成與自注意力機制運作原理

✴︎ BERT、GPT等預訓練模型與大型語言模型訓練方法

✴︎ 詞嵌入技術講解,結合Word2Vec、標記嵌入及位置編碼方法

✴︎ LoRA與PEFT微調技術,並涵蓋LLM.int8()量化技術

✴︎ Gradio工具應用介紹,支援互動式推理與多輪對話開發

✴︎ 量化技術分析,包括NF4、BitsAndBytes與QLoRA模型應用

✴︎ 模型評估方法,涵蓋困惑度、BLEU、ROUGE與HellaSwag指標

✴︎ 中文語料處理,涵蓋預訓練語料準備與AutoTokenizer應用

✴︎ 推理加速技術分析,包含DeepSpeed、FSDP與GPTQ高效實現

✴︎ 向量資料庫應用,講解PGVector安裝及詞向量檢索範例

https://youtu.be/S7MsG6xZp6Y

✴︎ 感知機架構,包括前饋網路與反向傳播演算法

✴︎ Sigmoid、ReLU啟動函數與Adam、RMSProp最佳化方法

✴︎ Transformer模型組成與自注意力機制運作原理

✴︎ BERT、GPT等預訓練模型與大型語言模型訓練方法

✴︎ 詞嵌入技術講解,結合Word2Vec、標記嵌入及位置編碼方法

✴︎ LoRA與PEFT微調技術,並涵蓋LLM.int8()量化技術

✴︎ Gradio工具應用介紹,支援互動式推理與多輪對話開發

✴︎ 量化技術分析,包括NF4、BitsAndBytes與QLoRA模型應用

✴︎ 模型評估方法,涵蓋困惑度、BLEU、ROUGE與HellaSwag指標

✴︎ 中文語料處理,涵蓋預訓練語料準備與AutoTokenizer應用

✴︎ 推理加速技術分析,包含DeepSpeed、FSDP與GPTQ高效實現

✴︎ 向量資料庫應用,講解PGVector安裝及詞向量檢索範例

目錄

第 1 章 自然語言處理

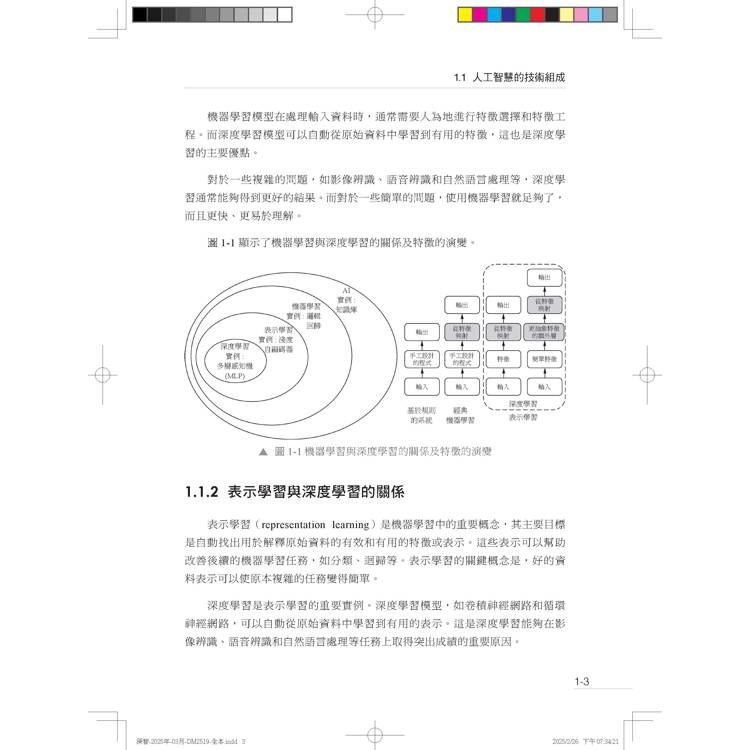

1.1 人工智慧的技術組成

1.1.1 機器學習和深度學習的區別

1.1.2 表示學習與深度學習的關係

1.2 自然語言處理的發展階段

1.3 規則驅動的方法

1.4 統計方法

1.4.1 隱馬可夫模型

1.4.2 條件隨機場

1.5 深度學習方法

1.5.1 Word2Vec 詞嵌入

1.5.2 循環神經網路

1.5.3 長短時記憶網路模型

1.5.4 門控循環單元模型

1.6 序列到序列模型

1.7 注意力機制

1.8 Transformer 模型

1.9 預訓練模型

1.10 大型語言模型

1.10.1 根據架構分類

1.10.2 根據訓練方式和預測方式分類

第 2 章 深度學習基礎

2.1 深度學習

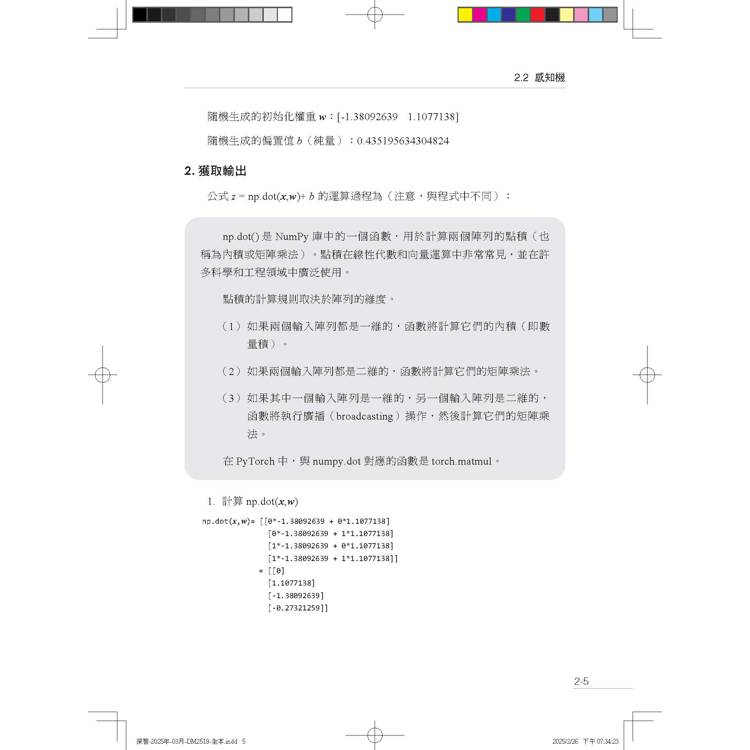

2.2 感知機

2.2.1 前饋網路

2.2.2 權重更新

2.2.3 反向傳播

2.3 啟動函數

2.3.1 常用啟動函數

2.3.2 新型啟動函數

2.4 最佳化函數(演算法)

2.4.1 梯度下降法

2.4.2 動量最佳化演算法

2.4.3 AdaGrad 最佳化演算法

2.4.4 RMSProp 最佳化演算法

2.4.5 Adam 最佳化演算法

2.4.6 AdamW 最佳化演算法

2.5 權值初始化

2.5.1 批次歸一化

2.5.2 層歸一化

2.5.3 RMSNorm

2.6 損失函數

2.6.1 均方誤差

2.6.2 均方根誤差

2.6.3 交叉熵損失

2.7 模型評估

2.7.1 偏差/ 方差

2.7.2 過擬合與欠擬合

2.8 正規化

2.9 SoftMax 函數

2.10 簡易神經網路架設

2.11 模型最佳化

2.11.1 梯度消失

2.11.2 梯度爆炸

2.11.3 最佳化方法

2.11.4 調參技巧

第 3 章 PyTorch 開發基礎

3.1 深度學習框架

3.2 PyTorch 簡介

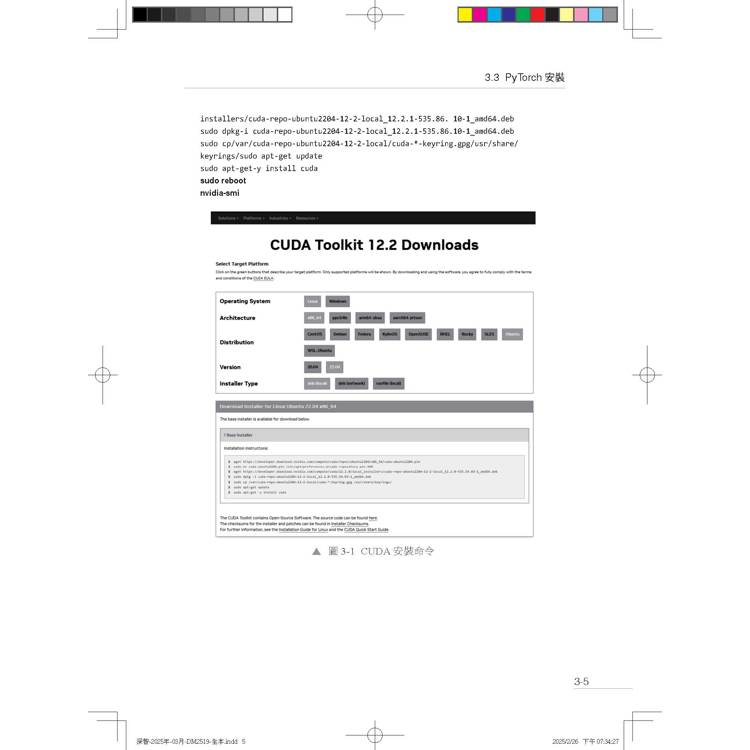

3.3 PyTorch 安裝

3.3.1 CUDA 安裝

3.3.2 阿里雲GPU 雲端伺服器

3.3.3 安裝PyTorch

3.3.4 安裝其他函數庫

3.3.5 檢查開發環境

3.4 張量

3.4.1 張量建立函數定義

3.4.2 張量建立函數清單

3.4.3 隨機張量:torch.randn()

3.4.4 張量操作

3.4.5 CUDA 張量

3.5 梯度計算

3.5.1 導數與偏導數

3.5.2 導數規則

3.5.3 梯度

3.5.4 公式推

3.5.5 自動梯度計算

3.5.6 程式解析

3.6 反向傳播

3.7 torch.nn 模組建構神經網路

3.7.1 nn.Linear 層

3.7.2 nn.Sigmoid 啟動函數

3.7.3 nn.BCELoss 損失函數

3.8 torch.optim 最佳化器

3.9 訓練、驗證和測試過程

3.10 用PyTorch 實現神經網路

3.10.1 實現單層感知機

3.10.2 實現簡單神經網路

3.10.3 用torch.nn 實現簡單神經網路

3.11 原始程式碼常用模組

3.11.1 nn.Parameter 類別

3.11.2 typing 模組

3.11.3 logging 模組

3.11.4 dataclasses

3.11.5 Fire 函數庫

第 4 章 Transformer 模型詳解

4.1 大型語言模型的簡介和分類

4.1.1 簡介

4.1.2 分類

4.2 Transformer 模型

4.2.1 模型組成

4.2.2 因果解碼器結構

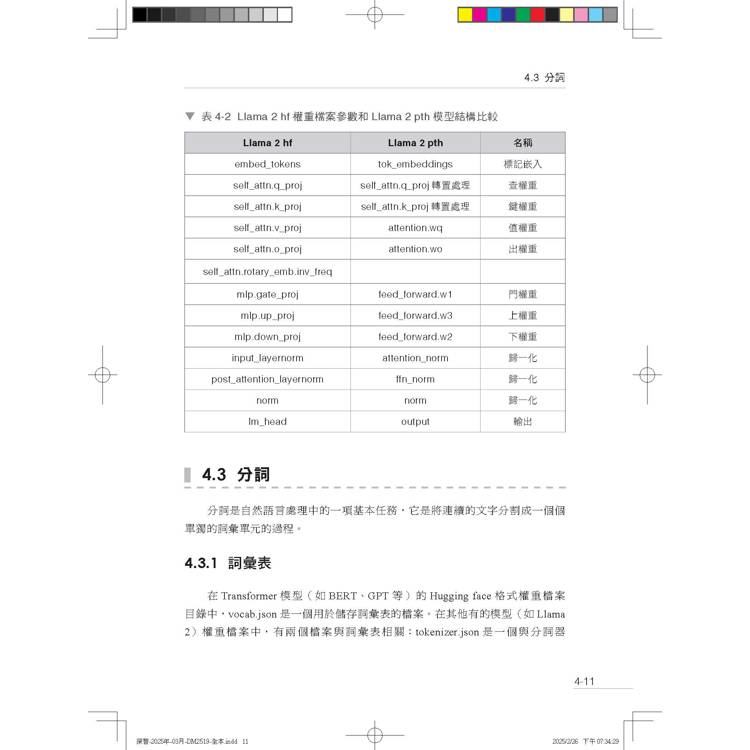

4.3 分詞

4.3.1 詞彙表

4.3.2 詞彙表的生成

4.3.3 分詞演算法

4.3.4 位元組對編碼

4.3.5 句子部分

4.3.6 分詞過程

4.3.7 詞彙索引

4.4 詞嵌入

4.4.1 標記嵌入

4.4.2 位置編碼

4.4.3 詞彙索引和詞嵌入向量關係

4.5 位置編碼方法

4.5.1 原生位置編碼

4.5.2 旋轉位置編碼

4.5.3 位置編碼的實現

4.5.4 Llama 位置編碼

4.5.5 長度擴充

4.6 自注意力機制

4.6.1 原理

4.6.2 注意力分數的計算

4.6.3 多頭注意力機制

4.6.4 分組查詢注意力

4.6.5 Llama 2 原始程式碼分析

4.7 殘差連接和層歸一化

4.7.1 預先歸一化

4.7.2 RMSNorm

4.7.3 Llama 2 原始程式碼分析

4.8 前饋網路

4.8.1 啟動函數

4.8.2 前饋網路隱藏層維度

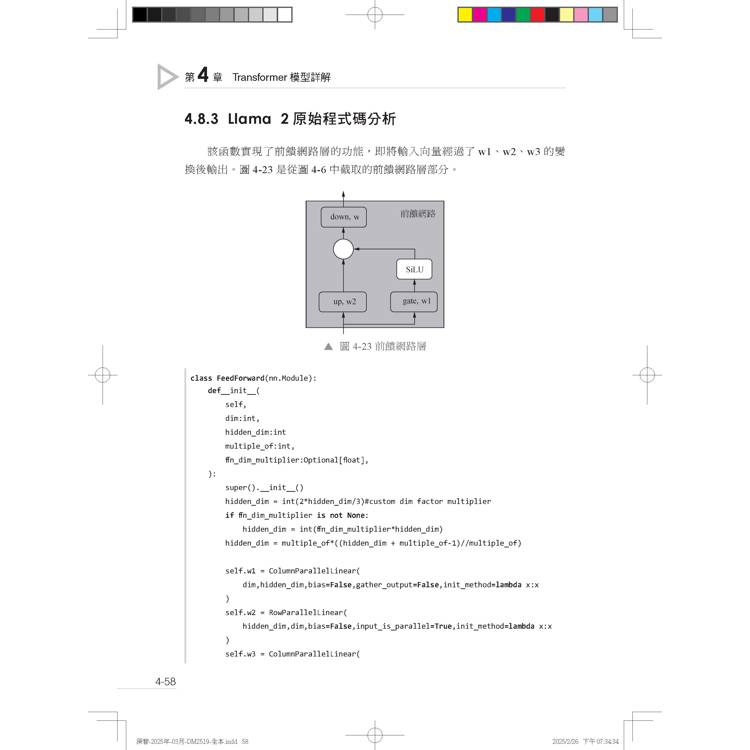

4.8.3 Llama 2 原始程式碼分析

4.8.4 演示程式

4.9 損失函數

4.10 遮罩

4.11 PyTorch 的nn.Transformer 模組

4.11.1 模組元件

4.11.2 __call__ 函數

4.11.3 最簡單的標準Transformer 模型

4.11.4 純解碼器模型

4.11.5 Llama 2 模型

第 5 章 大型語言模型

5.1 什麼是大型語言模型

5.2 GPT 簡介

5.3 Llama 簡介

5.4 Llama 的訓練

5.4.1 訓練資料

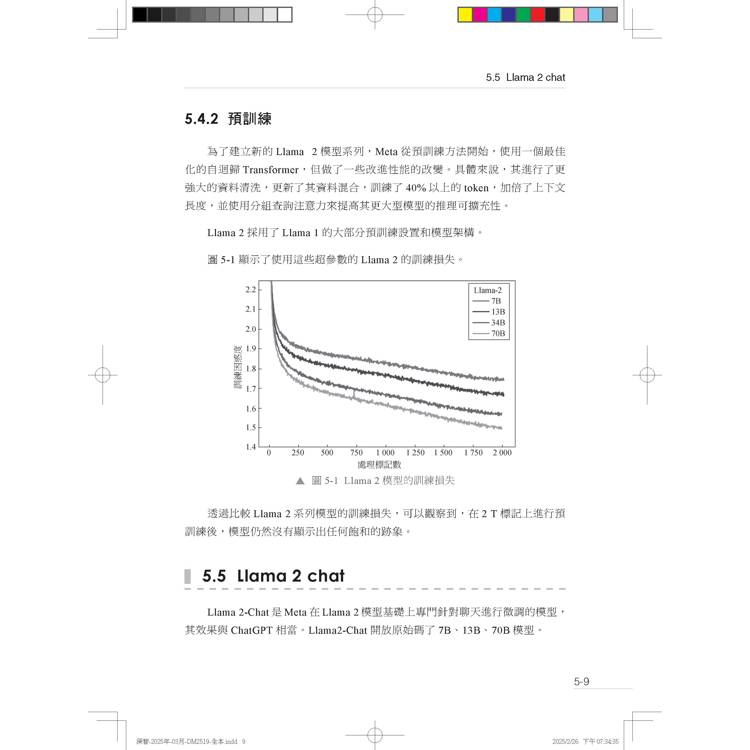

5.4.2 預訓練

5.5 Llama 2 chat

5.5.1 監督微調

5.5.2 基於人類回饋的強化學習

5.6 Llama 2 模型結構

5.7 Llama 2 權重資料夾

5.8 參數量計算

5.8.1 標準Transformer 解碼器模型

5.8.2 Llama 2 模型

5.8.3 用Transformers 模組計算

5.8.4 直接解析模型檔案

第 6 章 大型語言模型模型訓練

6.1 模型訓練的種類

6.2 Hugging Face 訓練環境

6.3 Transformers 函數庫

6.3.1 主要功能

6.3.2 函數

6.4 訓練程式

6.5 分詞處理

6.5.1 相關名詞

6.5.2 input IDs

6.5.3 特殊標記

6.5.4 AutoTokenizer

6.5.5 分詞

6.5.6 底線

6.5.7 填空

6.6 量化技術

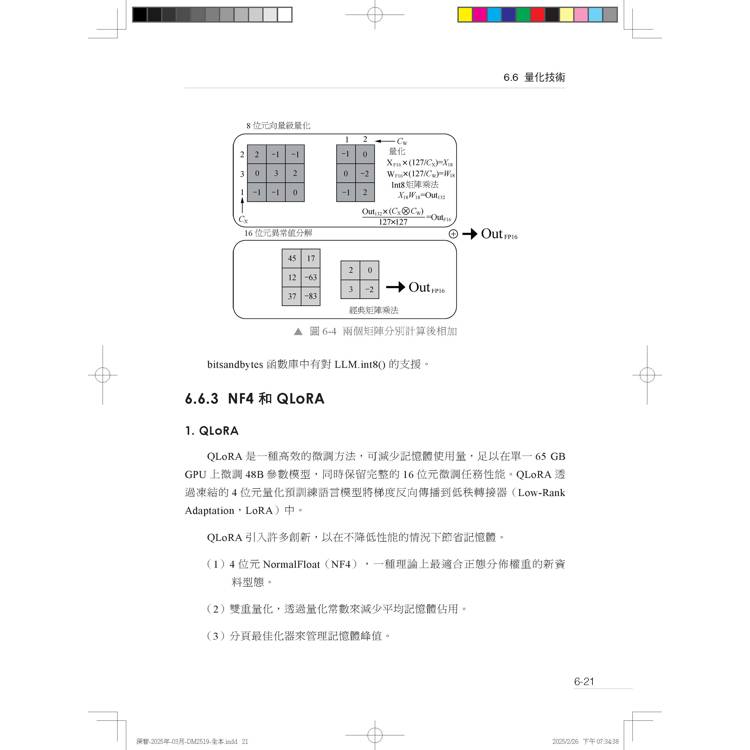

6.6.1 8 位元量化技術

6.6.2 LLM.int8()

6.6.3 NF4 和QLoRA

6.6.4 BitsAndBytes 模型

6.7 最佳化技術

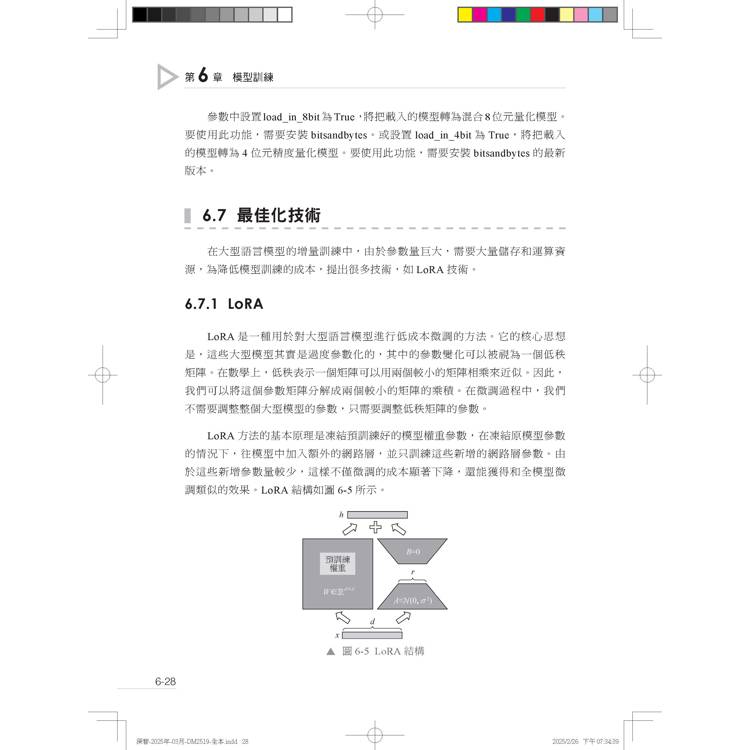

6.7.1 LoRA

6.7.2 PEFT 函數庫

6.8 訓練程式範例

6.8.1 匯入庫和函數

6.8.2 參數定義

6.8.3 載入模型

6.8.4 載入分詞器

6.8.5 資料前置處理

6.8.6 用LoRA 權重調整模型

6.8.7 LoRA 模型訓練

6.8.8 模型的合併

6.8.9 模型推理

6.8.10 載入多個LoRA 並隨時切換

6.9 加速技術和工具

6.9.1 DeepSpeed

6.9.2 FairScale

6.9.3 GPTQ

6.9.4 FSDP

6.10 超長上下文

6.10.1 外插能力

6.10.2 外插方法

6.10.3 StreamingLLM

第 7 章 模型微調

7.1 監督微調

7.2 開源資料集

7.3 資料集存取

7.3.1 datasets 函數庫

7.3.2 datasets 常用的函數和類別

7.3.3 載入資料集

7.3.4 資料集的處理

7.4 開放原始碼微調資料集

7.4.1 主要資料集

7.4.2 資料集格式

7.4.3 SQuAD

7.4.4 OSSIST1 資料集格式

7.4.5 格式轉換程式及分析

7.5 主要的微調模型

7.5.1 Alpaca 羊駝

7.5.2 Vicuna 小羊駝

7.5.3 LLaMA.cpp

7.5.4 Guanco

第 8 章 人類回饋強化學習

8.1 強化學習架構

8.2 演員- 評論家架構

8.3 近端策略最佳化架構

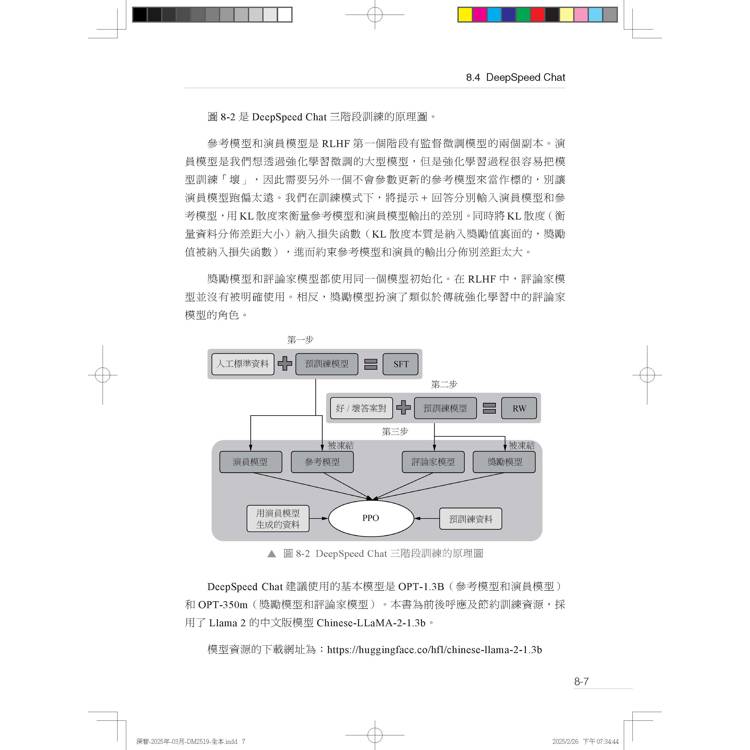

8.4 DeepSpeed Chat

8.5 開放原始碼RLHF 資料集

8.6 訓練資料讀取

8.6.1 第1 步:SFT 監督微調資料

8.6.2 第2 步:獎勵模型微調資料

8.6.3 第3 步:RLHF 微調資料

8.7 監督微調

8.8 獎勵模型微調

8.9 RLHF 微調

8.9.1 程式執行環境

8.9.2 準備訓練資料

8.9.3 建立模型

8.9.4 演員模型、參考模型生成對數機率

8.9.5 計算對數機率

8.9.6 計算期望獎勵

8.9.7 KL 散度

8.9.8 計算實際獎勵

8.9.9 優勢函數

8.9.10 計算優勢和回報

8.9.11 損失函數

第 9 章 模型推理

9.1 模型檔案

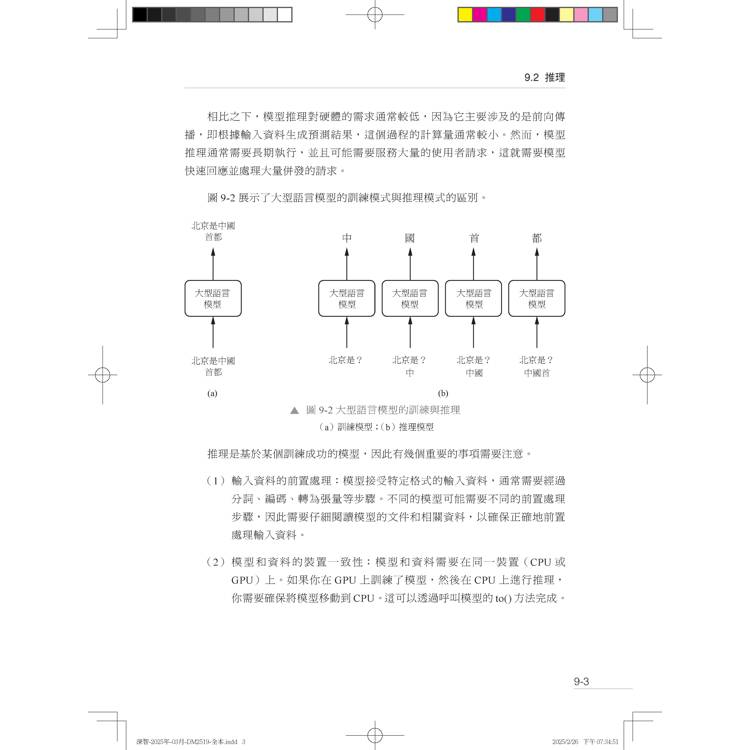

9.2 推理

9.2.1 單輪推理

9.2.2 多輪推理

9.3 GPU 推理

9.3.1 單卡

9.3.2 多卡

9.3.3 多機

9.4 Hugging Face Transformers 函數庫

9.4.1 簡介

9.4.2 Pipeline API

9.4.3 Model and Tokenizer API

9.4.4 單輪推理

9.4.5 多輪推理

9.4.6 LoRA 推理

9.4.7 vLLM

9.5 LLaMA.cpp

9.5.1 特色與優勢

9.5.2 模型量化

9.5.3 k-quant 量化

9.5.4 開發環境安裝

9.5.5 建構執行程式

9.5.6 轉換模型

9.5.7 推理

9.6 Gradio

9.6.1 簡介

9.6.2 基本用法

9.6.3 複雜互動

9.6.4 聊天機器人

9.6.5 Gradio 多輪推理

9.7 解碼策略

9.7.1 常見解碼策略

9.7.2 推理超參數

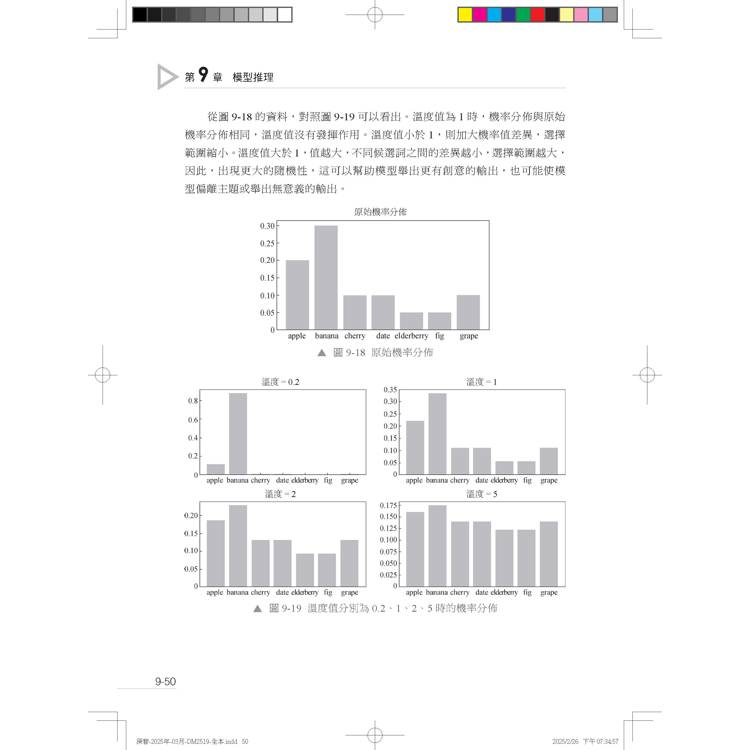

9.7.3 溫度

9.7.4 top-k

9.7.5 top-p

9.7.6 重複懲罰

9.7.7 程式實現

9.8 推理加速技術

9.8.1 簡介

9.8.2 純C 推理

9.8.3 投機採樣

9.8.4 Medusa

9.8.5 流式推理

第 10 章 中文私有模型開發

10.1 基本思路

10.2 中文詞彙表

10.3 模型下載

10.3.1 安裝Git LFS

10.3.2 獲取下載連結

10.3.3 直接點擊連結分檔案逐一下載

10.4 開發方案

10.4.1 演示系統開發

10.4.2 生產系統開發

10.4.3 實訓系統開發

10.5 中文語料

10.5.1 預訓練語料

10.5.2 微調資料集

第 11 章 模型評估

11.1 大型語言模型評估

11.2 評估指標

11.2.1 困惑度

11.2.2 HellaSwag

11.2.3 BLEU

11.2.4 ROUGE

11.3.5 METEOR

11.3 基於上下文的學習

11.4 Llama 2 預訓練模型的評估

11.5 MMLU

11.6 標準基準測試

11.7 程式生成

11.7.1 Human-Eval 程式生成基準測試

11.7.2 MBPP 程式生成基準測試

11.8 考試AGI Eval

11.9 GSM8K

11.10 世界知識

11.10.1 NaturalQuestions

11.10.2 TriviaQA

11.11 通義千問評測

11.12 BBH

第 12 章 用於RAG 的詞向量計算

12.1 資訊整合

12.2 向量資料庫

12.3 詞向量

12.4 嵌入向量生成模型

12.5 池化技術

12.6 計算詞向量

12.6.1 使用OpenAI

12.6.2 使用Hugging Face

12.6.3 使用Llama 2

12.7 批次生成嵌入向量

12.8 池化演算法

12.9 詞向量文件檢索

12.10 範例

12.10.1 PGVector 簡介

12.10.2 PGVector 安裝

12.10.3 向量資料庫操作

參考文獻

1.1 人工智慧的技術組成

1.1.1 機器學習和深度學習的區別

1.1.2 表示學習與深度學習的關係

1.2 自然語言處理的發展階段

1.3 規則驅動的方法

1.4 統計方法

1.4.1 隱馬可夫模型

1.4.2 條件隨機場

1.5 深度學習方法

1.5.1 Word2Vec 詞嵌入

1.5.2 循環神經網路

1.5.3 長短時記憶網路模型

1.5.4 門控循環單元模型

1.6 序列到序列模型

1.7 注意力機制

1.8 Transformer 模型

1.9 預訓練模型

1.10 大型語言模型

1.10.1 根據架構分類

1.10.2 根據訓練方式和預測方式分類

第 2 章 深度學習基礎

2.1 深度學習

2.2 感知機

2.2.1 前饋網路

2.2.2 權重更新

2.2.3 反向傳播

2.3 啟動函數

2.3.1 常用啟動函數

2.3.2 新型啟動函數

2.4 最佳化函數(演算法)

2.4.1 梯度下降法

2.4.2 動量最佳化演算法

2.4.3 AdaGrad 最佳化演算法

2.4.4 RMSProp 最佳化演算法

2.4.5 Adam 最佳化演算法

2.4.6 AdamW 最佳化演算法

2.5 權值初始化

2.5.1 批次歸一化

2.5.2 層歸一化

2.5.3 RMSNorm

2.6 損失函數

2.6.1 均方誤差

2.6.2 均方根誤差

2.6.3 交叉熵損失

2.7 模型評估

2.7.1 偏差/ 方差

2.7.2 過擬合與欠擬合

2.8 正規化

2.9 SoftMax 函數

2.10 簡易神經網路架設

2.11 模型最佳化

2.11.1 梯度消失

2.11.2 梯度爆炸

2.11.3 最佳化方法

2.11.4 調參技巧

第 3 章 PyTorch 開發基礎

3.1 深度學習框架

3.2 PyTorch 簡介

3.3 PyTorch 安裝

3.3.1 CUDA 安裝

3.3.2 阿里雲GPU 雲端伺服器

3.3.3 安裝PyTorch

3.3.4 安裝其他函數庫

3.3.5 檢查開發環境

3.4 張量

3.4.1 張量建立函數定義

3.4.2 張量建立函數清單

3.4.3 隨機張量:torch.randn()

3.4.4 張量操作

3.4.5 CUDA 張量

3.5 梯度計算

3.5.1 導數與偏導數

3.5.2 導數規則

3.5.3 梯度

3.5.4 公式推

3.5.5 自動梯度計算

3.5.6 程式解析

3.6 反向傳播

3.7 torch.nn 模組建構神經網路

3.7.1 nn.Linear 層

3.7.2 nn.Sigmoid 啟動函數

3.7.3 nn.BCELoss 損失函數

3.8 torch.optim 最佳化器

3.9 訓練、驗證和測試過程

3.10 用PyTorch 實現神經網路

3.10.1 實現單層感知機

3.10.2 實現簡單神經網路

3.10.3 用torch.nn 實現簡單神經網路

3.11 原始程式碼常用模組

3.11.1 nn.Parameter 類別

3.11.2 typing 模組

3.11.3 logging 模組

3.11.4 dataclasses

3.11.5 Fire 函數庫

第 4 章 Transformer 模型詳解

4.1 大型語言模型的簡介和分類

4.1.1 簡介

4.1.2 分類

4.2 Transformer 模型

4.2.1 模型組成

4.2.2 因果解碼器結構

4.3 分詞

4.3.1 詞彙表

4.3.2 詞彙表的生成

4.3.3 分詞演算法

4.3.4 位元組對編碼

4.3.5 句子部分

4.3.6 分詞過程

4.3.7 詞彙索引

4.4 詞嵌入

4.4.1 標記嵌入

4.4.2 位置編碼

4.4.3 詞彙索引和詞嵌入向量關係

4.5 位置編碼方法

4.5.1 原生位置編碼

4.5.2 旋轉位置編碼

4.5.3 位置編碼的實現

4.5.4 Llama 位置編碼

4.5.5 長度擴充

4.6 自注意力機制

4.6.1 原理

4.6.2 注意力分數的計算

4.6.3 多頭注意力機制

4.6.4 分組查詢注意力

4.6.5 Llama 2 原始程式碼分析

4.7 殘差連接和層歸一化

4.7.1 預先歸一化

4.7.2 RMSNorm

4.7.3 Llama 2 原始程式碼分析

4.8 前饋網路

4.8.1 啟動函數

4.8.2 前饋網路隱藏層維度

4.8.3 Llama 2 原始程式碼分析

4.8.4 演示程式

4.9 損失函數

4.10 遮罩

4.11 PyTorch 的nn.Transformer 模組

4.11.1 模組元件

4.11.2 __call__ 函數

4.11.3 最簡單的標準Transformer 模型

4.11.4 純解碼器模型

4.11.5 Llama 2 模型

第 5 章 大型語言模型

5.1 什麼是大型語言模型

5.2 GPT 簡介

5.3 Llama 簡介

5.4 Llama 的訓練

5.4.1 訓練資料

5.4.2 預訓練

5.5 Llama 2 chat

5.5.1 監督微調

5.5.2 基於人類回饋的強化學習

5.6 Llama 2 模型結構

5.7 Llama 2 權重資料夾

5.8 參數量計算

5.8.1 標準Transformer 解碼器模型

5.8.2 Llama 2 模型

5.8.3 用Transformers 模組計算

5.8.4 直接解析模型檔案

第 6 章 大型語言模型模型訓練

6.1 模型訓練的種類

6.2 Hugging Face 訓練環境

6.3 Transformers 函數庫

6.3.1 主要功能

6.3.2 函數

6.4 訓練程式

6.5 分詞處理

6.5.1 相關名詞

6.5.2 input IDs

6.5.3 特殊標記

6.5.4 AutoTokenizer

6.5.5 分詞

6.5.6 底線

6.5.7 填空

6.6 量化技術

6.6.1 8 位元量化技術

6.6.2 LLM.int8()

6.6.3 NF4 和QLoRA

6.6.4 BitsAndBytes 模型

6.7 最佳化技術

6.7.1 LoRA

6.7.2 PEFT 函數庫

6.8 訓練程式範例

6.8.1 匯入庫和函數

6.8.2 參數定義

6.8.3 載入模型

6.8.4 載入分詞器

6.8.5 資料前置處理

6.8.6 用LoRA 權重調整模型

6.8.7 LoRA 模型訓練

6.8.8 模型的合併

6.8.9 模型推理

6.8.10 載入多個LoRA 並隨時切換

6.9 加速技術和工具

6.9.1 DeepSpeed

6.9.2 FairScale

6.9.3 GPTQ

6.9.4 FSDP

6.10 超長上下文

6.10.1 外插能力

6.10.2 外插方法

6.10.3 StreamingLLM

第 7 章 模型微調

7.1 監督微調

7.2 開源資料集

7.3 資料集存取

7.3.1 datasets 函數庫

7.3.2 datasets 常用的函數和類別

7.3.3 載入資料集

7.3.4 資料集的處理

7.4 開放原始碼微調資料集

7.4.1 主要資料集

7.4.2 資料集格式

7.4.3 SQuAD

7.4.4 OSSIST1 資料集格式

7.4.5 格式轉換程式及分析

7.5 主要的微調模型

7.5.1 Alpaca 羊駝

7.5.2 Vicuna 小羊駝

7.5.3 LLaMA.cpp

7.5.4 Guanco

第 8 章 人類回饋強化學習

8.1 強化學習架構

8.2 演員- 評論家架構

8.3 近端策略最佳化架構

8.4 DeepSpeed Chat

8.5 開放原始碼RLHF 資料集

8.6 訓練資料讀取

8.6.1 第1 步:SFT 監督微調資料

8.6.2 第2 步:獎勵模型微調資料

8.6.3 第3 步:RLHF 微調資料

8.7 監督微調

8.8 獎勵模型微調

8.9 RLHF 微調

8.9.1 程式執行環境

8.9.2 準備訓練資料

8.9.3 建立模型

8.9.4 演員模型、參考模型生成對數機率

8.9.5 計算對數機率

8.9.6 計算期望獎勵

8.9.7 KL 散度

8.9.8 計算實際獎勵

8.9.9 優勢函數

8.9.10 計算優勢和回報

8.9.11 損失函數

第 9 章 模型推理

9.1 模型檔案

9.2 推理

9.2.1 單輪推理

9.2.2 多輪推理

9.3 GPU 推理

9.3.1 單卡

9.3.2 多卡

9.3.3 多機

9.4 Hugging Face Transformers 函數庫

9.4.1 簡介

9.4.2 Pipeline API

9.4.3 Model and Tokenizer API

9.4.4 單輪推理

9.4.5 多輪推理

9.4.6 LoRA 推理

9.4.7 vLLM

9.5 LLaMA.cpp

9.5.1 特色與優勢

9.5.2 模型量化

9.5.3 k-quant 量化

9.5.4 開發環境安裝

9.5.5 建構執行程式

9.5.6 轉換模型

9.5.7 推理

9.6 Gradio

9.6.1 簡介

9.6.2 基本用法

9.6.3 複雜互動

9.6.4 聊天機器人

9.6.5 Gradio 多輪推理

9.7 解碼策略

9.7.1 常見解碼策略

9.7.2 推理超參數

9.7.3 溫度

9.7.4 top-k

9.7.5 top-p

9.7.6 重複懲罰

9.7.7 程式實現

9.8 推理加速技術

9.8.1 簡介

9.8.2 純C 推理

9.8.3 投機採樣

9.8.4 Medusa

9.8.5 流式推理

第 10 章 中文私有模型開發

10.1 基本思路

10.2 中文詞彙表

10.3 模型下載

10.3.1 安裝Git LFS

10.3.2 獲取下載連結

10.3.3 直接點擊連結分檔案逐一下載

10.4 開發方案

10.4.1 演示系統開發

10.4.2 生產系統開發

10.4.3 實訓系統開發

10.5 中文語料

10.5.1 預訓練語料

10.5.2 微調資料集

第 11 章 模型評估

11.1 大型語言模型評估

11.2 評估指標

11.2.1 困惑度

11.2.2 HellaSwag

11.2.3 BLEU

11.2.4 ROUGE

11.3.5 METEOR

11.3 基於上下文的學習

11.4 Llama 2 預訓練模型的評估

11.5 MMLU

11.6 標準基準測試

11.7 程式生成

11.7.1 Human-Eval 程式生成基準測試

11.7.2 MBPP 程式生成基準測試

11.8 考試AGI Eval

11.9 GSM8K

11.10 世界知識

11.10.1 NaturalQuestions

11.10.2 TriviaQA

11.11 通義千問評測

11.12 BBH

第 12 章 用於RAG 的詞向量計算

12.1 資訊整合

12.2 向量資料庫

12.3 詞向量

12.4 嵌入向量生成模型

12.5 池化技術

12.6 計算詞向量

12.6.1 使用OpenAI

12.6.2 使用Hugging Face

12.6.3 使用Llama 2

12.7 批次生成嵌入向量

12.8 池化演算法

12.9 詞向量文件檢索

12.10 範例

12.10.1 PGVector 簡介

12.10.2 PGVector 安裝

12.10.3 向量資料庫操作

參考文獻

序/導讀

序言

在ChatGPT的成功推動下,人工智慧(artificial intelligence,AI)技術的主要研究焦點已從電腦視覺逐漸轉向自然語言處理(natural language processing,NLP)。這使得原本相對邊緣的自然語言處理技術逐漸走向了舞臺中心。儘管自然語言處理的研究者相較於電腦視覺(computer vision,CV)領域來說少,但經過幾十年的發展,其累積的技術成果也十分豐富。以 ChatGPT及其背後的GP(Generative Pretrained Transformer)模型為代表的大型語言模型(LLM)技術的成功,不是一夜之間的突變,而是基於多年技術累積取得的一次重大突破。

但是,並非所有的自然語言處理技術都被大型語言模型的開發所採用。一些技術路線已被放棄,一些雖然獲得了發展,但已被更優秀的技術所取代。在大型語言模型技術的後續發展中,這些被拋棄或替代的技術仍有可能被重新研究和改進。本書旨在是讓讀者了解主流大型語言模型所採用的技術,而非去開發新的大型語言模型。因此,我們主要介紹了 GPT 系列及開放原始碼 Llama 2 模型所採用的技術,對其他技術並未進行探討,例如知名的詞嵌入(word embeddings)技術 Word2Vec。

現在的大型語言模型基本上都是基於Transformer架構。相較於標準的編碼器 - 解碼器(Encoder-Decoder)結構,如今的GPT系列產品及Llama 1、Llama 2都採用了單解碼器結構。本書以Transformer模型架構為基礎,特別注意了純解碼器技術方向,並對相關技術進行了詳細的闡述。

在ChatGPT的成功推動下,人工智慧(artificial intelligence,AI)技術的主要研究焦點已從電腦視覺逐漸轉向自然語言處理(natural language processing,NLP)。這使得原本相對邊緣的自然語言處理技術逐漸走向了舞臺中心。儘管自然語言處理的研究者相較於電腦視覺(computer vision,CV)領域來說少,但經過幾十年的發展,其累積的技術成果也十分豐富。以 ChatGPT及其背後的GP(Generative Pretrained Transformer)模型為代表的大型語言模型(LLM)技術的成功,不是一夜之間的突變,而是基於多年技術累積取得的一次重大突破。

但是,並非所有的自然語言處理技術都被大型語言模型的開發所採用。一些技術路線已被放棄,一些雖然獲得了發展,但已被更優秀的技術所取代。在大型語言模型技術的後續發展中,這些被拋棄或替代的技術仍有可能被重新研究和改進。本書旨在是讓讀者了解主流大型語言模型所採用的技術,而非去開發新的大型語言模型。因此,我們主要介紹了 GPT 系列及開放原始碼 Llama 2 模型所採用的技術,對其他技術並未進行探討,例如知名的詞嵌入(word embeddings)技術 Word2Vec。

現在的大型語言模型基本上都是基於Transformer架構。相較於標準的編碼器 - 解碼器(Encoder-Decoder)結構,如今的GPT系列產品及Llama 1、Llama 2都採用了單解碼器結構。本書以Transformer模型架構為基礎,特別注意了純解碼器技術方向,並對相關技術進行了詳細的闡述。

配送方式

-

台灣

- 國內宅配:本島、離島

-

到店取貨:

不限金額免運費

-

海外

- 國際快遞:全球

-

港澳店取:

訂購/退換貨須知

退換貨須知:

**提醒您,鑑賞期不等於試用期,退回商品須為全新狀態**

-

依據「消費者保護法」第19條及行政院消費者保護處公告之「通訊交易解除權合理例外情事適用準則」,以下商品購買後,除商品本身有瑕疵外,將不提供7天的猶豫期:

- 易於腐敗、保存期限較短或解約時即將逾期。(如:生鮮食品)

- 依消費者要求所為之客製化給付。(客製化商品)

- 報紙、期刊或雜誌。(含MOOK、外文雜誌)

- 經消費者拆封之影音商品或電腦軟體。

- 非以有形媒介提供之數位內容或一經提供即為完成之線上服務,經消費者事先同意始提供。(如:電子書、電子雜誌、下載版軟體、虛擬商品…等)

- 已拆封之個人衛生用品。(如:內衣褲、刮鬍刀、除毛刀…等)

- 若非上列種類商品,均享有到貨7天的猶豫期(含例假日)。

- 辦理退換貨時,商品(組合商品恕無法接受單獨退貨)必須是您收到商品時的原始狀態(包含商品本體、配件、贈品、保證書、所有附隨資料文件及原廠內外包裝…等),請勿直接使用原廠包裝寄送,或於原廠包裝上黏貼紙張或書寫文字。

- 退回商品若無法回復原狀,將請您負擔回復原狀所需費用,嚴重時將影響您的退貨權益。

商品評價