LLM × 網路爬蟲終極實戰:n8n 串接資料爬取 × Qdrant × RAG 打造本機 AI Agent

內容簡介

內容介紹:

身處 LLM 時代的必備技能

AI 爬蟲與資料檢索的全本機工作流

你還在用傳統的方法爬取網路資料嗎?

還在手動分析 HTML 網頁結構、逐一定位網頁元素、再手刻爬蟲程式嗎?

身處 AI 世代,是時候該學習更聰明、更高效的資料收集方法,

讓你坐在電腦前,喝著咖啡、悠閒地看著 AI 為你自動爬取網路資料。

在 AI 飆速發展的今天,傳統網路爬蟲技術正迎來全新的變革。

過去,Python 爬蟲程式的開發者必須自行剖析 HTML 網頁結構,撰寫繁瑣複雜的資料擷取規則與步驟;如今,隨著 LLM 的普及,AI 已能協助我們理解 HTML 網頁結構、定位網頁資料,甚至能夠自動化建立整個爬取流程,大幅提升開發效率。

本書從 HTML 結構解析入門,循序講解 BeautifulSoup + CSS 選擇器、lxml + XPath 表達式、正規表達式等核心技術,再深入 Selenium 模擬瀏覽器互動及 Scrapy 爬蟲框架的專業應用,帶領讀者全面掌握靜態與動態網頁擷取技術。更進一步結合 Playwright 自動化瀏覽器、以及 AI 驅動的爬蟲框架 Crawl4AI 和 ScrapeGraphAI,讓 LLM 成為理解與提取網頁資料的主力。

不只如此,本書採用 n8n × Ollama 全本機架構,無需 API Key、無需 Docker,即可整合 SearXNG 搜尋引擎、Crawl4AI API 資料爬取、Qdrant 向量資料庫與 RAG 知識檢索生成,最終打造出 MCP + AI Agent 自動化流程 ⸺ 從搜尋、爬取到資料處理與知識生成一手包辦!

本書特色:

用 AI 分析 HTML 結構建立 Python 網路爬蟲

▸全面掌握靜態與動態 HTML 網頁擷取技術,CSS Selector、XPath 一次上手

▸實戰演練 BeautifulSoup、Selenium、Scrapy 經典 Python 爬蟲框架

Python × LLM 建立 AI 網路爬蟲

▸整合 OpenAI、Gemini、Groq、Ollama 等多種 LLM,打造智慧爬蟲系統

▸運用 AI 驅動的爬蟲技術 Crawl4AI 與 ScrapeGraphAI,自動理解並提取網頁內容

▸結合非同步程式設計,提升資料抓取效率與彈性

整合 Python × AI 網路爬蟲的 AI 工作流程:n8n

▸以視覺化介面建立自動化流程,輕鬆整合搜尋、爬取與資料處理

▸結合 Qdrant 向量資料庫 × RAG 技術,打造個人化知識檢索系統

▸構建全本機 AI Agent 工作流,實現從資料擷取到生成的自動化流程

身處 LLM 時代的必備技能

AI 爬蟲與資料檢索的全本機工作流

你還在用傳統的方法爬取網路資料嗎?

還在手動分析 HTML 網頁結構、逐一定位網頁元素、再手刻爬蟲程式嗎?

身處 AI 世代,是時候該學習更聰明、更高效的資料收集方法,

讓你坐在電腦前,喝著咖啡、悠閒地看著 AI 為你自動爬取網路資料。

在 AI 飆速發展的今天,傳統網路爬蟲技術正迎來全新的變革。

過去,Python 爬蟲程式的開發者必須自行剖析 HTML 網頁結構,撰寫繁瑣複雜的資料擷取規則與步驟;如今,隨著 LLM 的普及,AI 已能協助我們理解 HTML 網頁結構、定位網頁資料,甚至能夠自動化建立整個爬取流程,大幅提升開發效率。

本書從 HTML 結構解析入門,循序講解 BeautifulSoup + CSS 選擇器、lxml + XPath 表達式、正規表達式等核心技術,再深入 Selenium 模擬瀏覽器互動及 Scrapy 爬蟲框架的專業應用,帶領讀者全面掌握靜態與動態網頁擷取技術。更進一步結合 Playwright 自動化瀏覽器、以及 AI 驅動的爬蟲框架 Crawl4AI 和 ScrapeGraphAI,讓 LLM 成為理解與提取網頁資料的主力。

不只如此,本書採用 n8n × Ollama 全本機架構,無需 API Key、無需 Docker,即可整合 SearXNG 搜尋引擎、Crawl4AI API 資料爬取、Qdrant 向量資料庫與 RAG 知識檢索生成,最終打造出 MCP + AI Agent 自動化流程 ⸺ 從搜尋、爬取到資料處理與知識生成一手包辦!

本書特色:

用 AI 分析 HTML 結構建立 Python 網路爬蟲

▸全面掌握靜態與動態 HTML 網頁擷取技術,CSS Selector、XPath 一次上手

▸實戰演練 BeautifulSoup、Selenium、Scrapy 經典 Python 爬蟲框架

Python × LLM 建立 AI 網路爬蟲

▸整合 OpenAI、Gemini、Groq、Ollama 等多種 LLM,打造智慧爬蟲系統

▸運用 AI 驅動的爬蟲技術 Crawl4AI 與 ScrapeGraphAI,自動理解並提取網頁內容

▸結合非同步程式設計,提升資料抓取效率與彈性

整合 Python × AI 網路爬蟲的 AI 工作流程:n8n

▸以視覺化介面建立自動化流程,輕鬆整合搜尋、爬取與資料處理

▸結合 Qdrant 向量資料庫 × RAG 技術,打造個人化知識檢索系統

▸構建全本機 AI Agent 工作流,實現從資料擷取到生成的自動化流程

目錄

目錄:

▌第 1 章 HTML、JSON 與網路爬蟲的基礎

1-1 網路爬蟲的基礎

1-2 網路爬蟲的相關技術

1-3 HTML 標籤語法與結構

1-4 CSV 與 JSON

1-5 Python × AI 網路爬蟲的相關函式庫

▌第 2 章 從網路取得資料

2-1 認識 HTTP 標頭與 httpbin.org 服務

2-2 使用 Requests 送出 HTTP 請求

2-3 取得 HTTP 回應內容

2-4 送出進階的 HTTP 請求

2-5 錯誤 / 例外處理與檔案存取

▌第 3 章 擷取靜態 HTML 網頁資料

3-1 在 HTML 網頁定位目標資料

3-2 使用 BeautifulSoup 剖析 HTML 網頁

3-3 分析靜態 HTML 網頁

3-4 使用 find() 函式搜尋 HTML 網頁

3-5 使用正規表達式搜尋 HTML 網頁

▌第 4 章 使用 CSS 選擇器爬取資料

4-1 認識 CSS 層級式樣式表

4-2 使用 CSS 選擇器定位 HTML 標籤

4-3 Google Chrome 開發人員工具

4-4 ChatGPT 應用:找出定位 HTML 標籤的 CSS 選擇器

4-5 在 BeautifulSoup 使用 CSS 選擇器

▌第 5 章 走訪 HTML 網頁取出資料與資料儲存

5-1 如何走訪 HTML 網頁

5-2 走訪 HTML 網頁取得資料

5-3 修改 HTML 網頁來爬取資料

5-4 資料清理

5-5 將取得資料儲存成 CSV 和 JSON 檔案

5-6 從網路下載圖檔

▌第 6 章 使用 XPath 表達式與 lxml 套件建立爬蟲程式

6-1 XPath 與 lxml 套件的基礎

6-2 使用 Requests 和 lxml 套件

6-3 XPath 資料模型

6-4 XPath 基本語法

6-5 XPath 運算子與函式

6-6 ChatGPT 應用:學習 XPath 表達式查詢 HTML 標籤

▌第 7 章 Selenium 表單互動與動態網頁擷取

7-1 認識動態網頁

7-2 安裝 Selenium

7-3 Selenium 的基本使用

7-4 定位網頁資料與例外處理

7-5 與 HTML 表單進行互動

7-6 JavaScript 動態網頁擷取

▌第 8 章 Scrapy 爬蟲框架

8-1 Scrapy 爬蟲框架的基礎

8-2 使用 Scrapy Shell

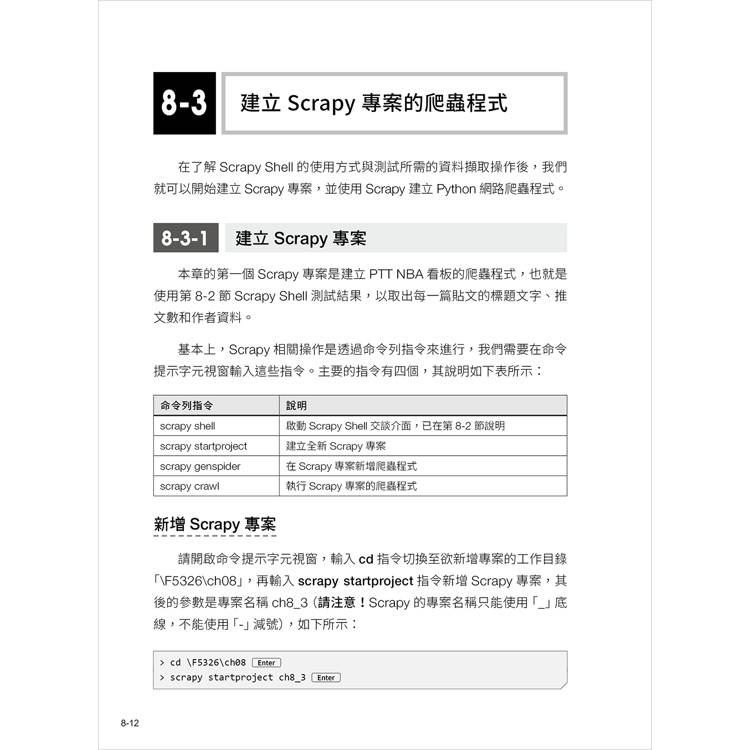

8-3 建立 Scrapy 專案的爬蟲程式

8-4 在專案使用 Item 和 Item Pipeline

8-5 輸出 Scrapy 爬取的資料

▌第 9 章 Python × ChatGPT 網路爬蟲

9-1 Python 爬蟲程式的常見問題

9-2 Requests + BeautifulSoup 爬蟲實作案例

9-3 Selenium 爬蟲實作案例

9-4 Scrapy 爬蟲實作案例

▌第 10 章 在 Python 使用 LLM 大型語言模型

10-1 認識生成式 AI 與 LLM

10-2 使用 OpenAI 的 ChatGPT API

10-3 使用 Google 的 Gemini API

10-4 LLM API 服務:Groq API

10-5 使用 Ollama 打造本機 LLM

▌第 11 章 Python × AI 網路爬蟲(一):非同步程式設計 + Crawl4AI

11-1 Python 非同步程式設計

11-2 Crawl4AI 的基本使用

11-3 內容篩選和客製化 Markdown 輸出

11-4 CSS 與 XPath 的 Schema 資料擷取

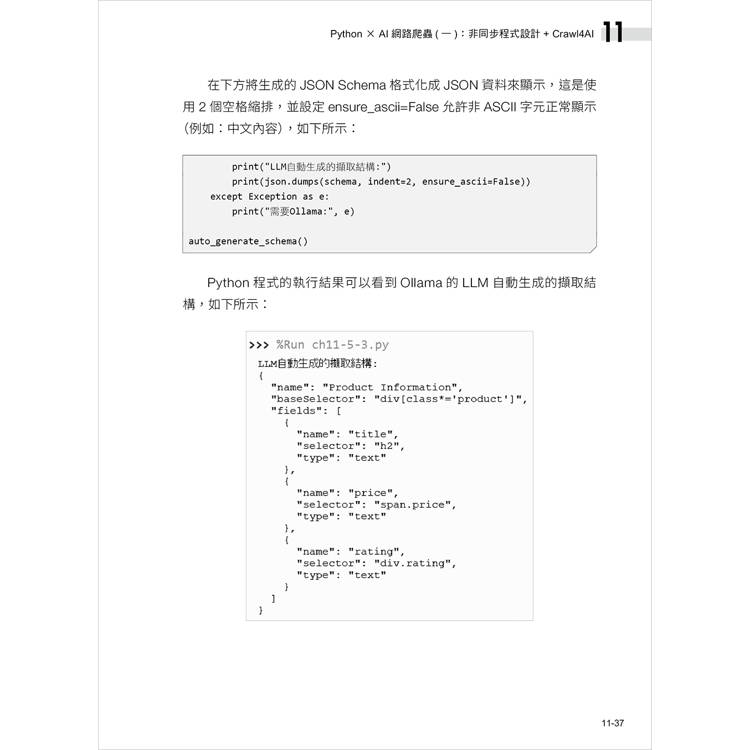

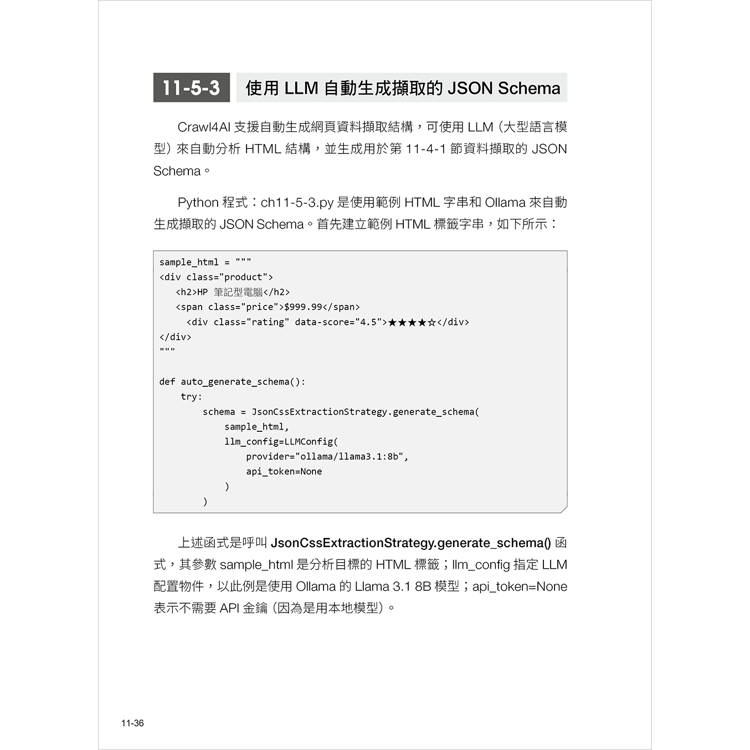

11-5 LLM 驅動的 AI 資料篩選與提取

11-6 深度爬取和 JavaScript 動態網頁處理

▌第 12 章 Python × AI 網路爬蟲(二):ScrapeGraphAI

12-1 ScrapeGraphAI 簡介與環境設定

12-2 基礎 Graph:SmartScraperGraph 與 SmartScraperMultiGraph

12-3 文字轉語音 Graph:SpeechGraph

12-4 腳本生成 Graph:ScriptCreatorGraph 與 ScriptCreatorMultiGraph

▌第 13 章 視覺化 AI 工作流程:n8n

13-1 認識 n8n 與工作流程

13-2 安裝與啟動 n8n 社群版

13-3 建立你的第 1 個工作流程

13-4 建立你的第 1 個 AI 工作流程

13-5 n8n 常用節點的使用

▌第 14 章 爬取知識庫的資料:SearXNG + Crawl4AI API

14-1 安裝、啟動與使用 Crawl4AI API

14-2 使用 SearXNG API

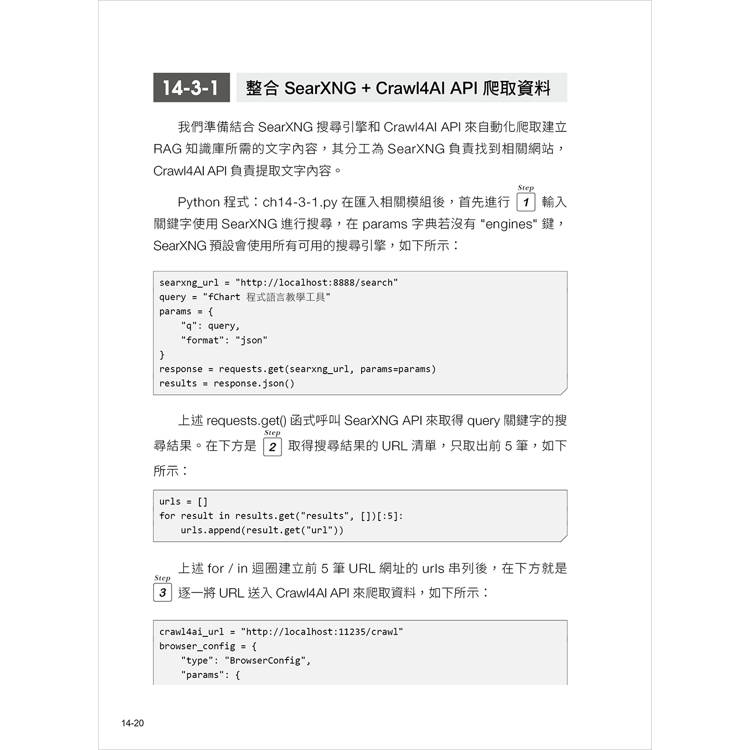

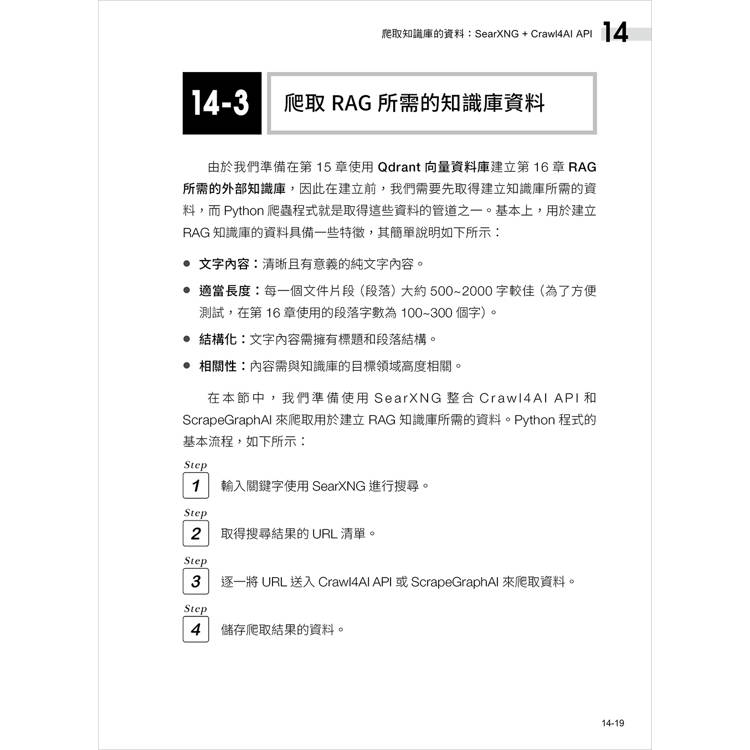

14-3 爬取 RAG 所需的知識庫資料

14-4 在 n8n 建立爬蟲程式和使用 SearXNG + Crawl4AI API

▌第 15 章 建立你自己的知識庫:Qdrant 向量資料庫

15-1 Embedding 模型:文字資料向量化

15-2 安裝與使用 Qdrant 向量資料庫

15-3 在 Python 程式使用 Qdrant 向量資料庫

15-4 建立你的知識庫:將文本內容存入向量資料庫

15-5 在 n8n 使用 Qdrant 向量資料庫

▌第 16 章 打造你自己的客製化 LLM:AI Agent、MCP 與 RAG 系統

16-1 認識 AI Assistant、RAG、AI Agent 和 MCP

16-2 使用 Python 手把手打造本機 RAG 系統

16-3 n8n 的 AI Agent 與 Tool

16-4 n8n 的 AI Agent 與 MCP

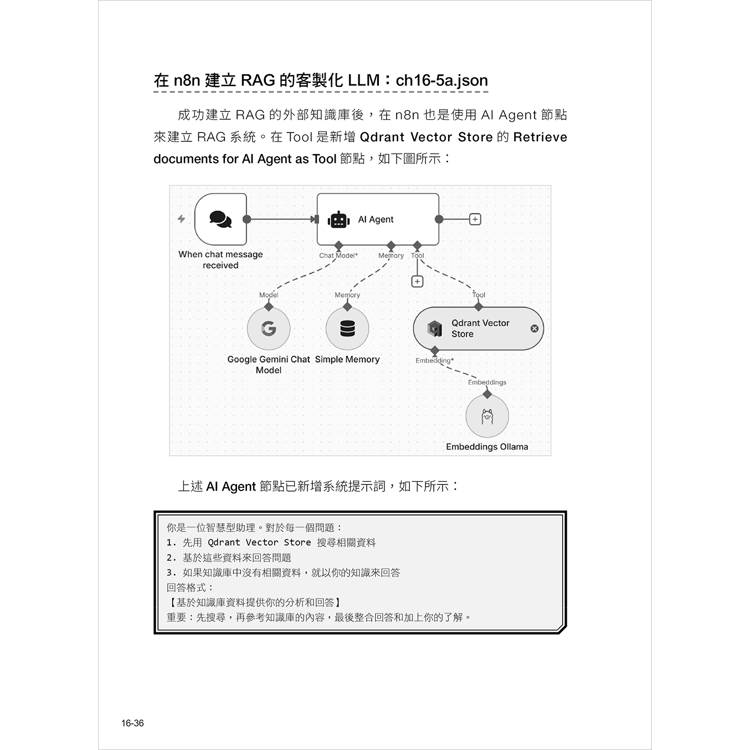

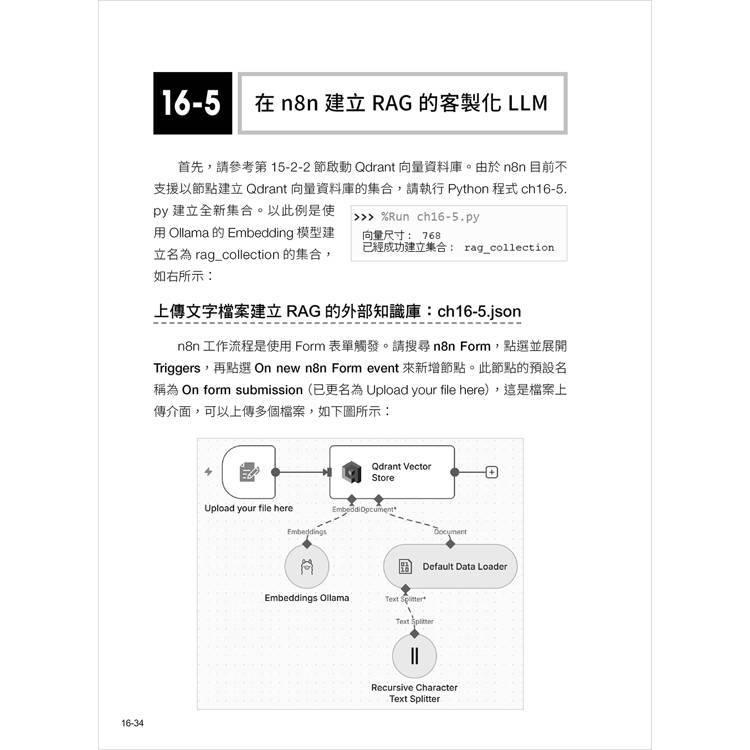

16-5 在 n8n 建立 RAG 的客製化 LLM

▌附錄 A Python 開發環境:Anaconda 與 WinPython 客製化套件(電子書)

A-1 建立 Anaconda 的 Python 開發環境

A-2 安裝本書客製化的 WinPython 可攜式套件

A-3 使用 Thonny 的 Python IDE

▌第 1 章 HTML、JSON 與網路爬蟲的基礎

1-1 網路爬蟲的基礎

1-2 網路爬蟲的相關技術

1-3 HTML 標籤語法與結構

1-4 CSV 與 JSON

1-5 Python × AI 網路爬蟲的相關函式庫

▌第 2 章 從網路取得資料

2-1 認識 HTTP 標頭與 httpbin.org 服務

2-2 使用 Requests 送出 HTTP 請求

2-3 取得 HTTP 回應內容

2-4 送出進階的 HTTP 請求

2-5 錯誤 / 例外處理與檔案存取

▌第 3 章 擷取靜態 HTML 網頁資料

3-1 在 HTML 網頁定位目標資料

3-2 使用 BeautifulSoup 剖析 HTML 網頁

3-3 分析靜態 HTML 網頁

3-4 使用 find() 函式搜尋 HTML 網頁

3-5 使用正規表達式搜尋 HTML 網頁

▌第 4 章 使用 CSS 選擇器爬取資料

4-1 認識 CSS 層級式樣式表

4-2 使用 CSS 選擇器定位 HTML 標籤

4-3 Google Chrome 開發人員工具

4-4 ChatGPT 應用:找出定位 HTML 標籤的 CSS 選擇器

4-5 在 BeautifulSoup 使用 CSS 選擇器

▌第 5 章 走訪 HTML 網頁取出資料與資料儲存

5-1 如何走訪 HTML 網頁

5-2 走訪 HTML 網頁取得資料

5-3 修改 HTML 網頁來爬取資料

5-4 資料清理

5-5 將取得資料儲存成 CSV 和 JSON 檔案

5-6 從網路下載圖檔

▌第 6 章 使用 XPath 表達式與 lxml 套件建立爬蟲程式

6-1 XPath 與 lxml 套件的基礎

6-2 使用 Requests 和 lxml 套件

6-3 XPath 資料模型

6-4 XPath 基本語法

6-5 XPath 運算子與函式

6-6 ChatGPT 應用:學習 XPath 表達式查詢 HTML 標籤

▌第 7 章 Selenium 表單互動與動態網頁擷取

7-1 認識動態網頁

7-2 安裝 Selenium

7-3 Selenium 的基本使用

7-4 定位網頁資料與例外處理

7-5 與 HTML 表單進行互動

7-6 JavaScript 動態網頁擷取

▌第 8 章 Scrapy 爬蟲框架

8-1 Scrapy 爬蟲框架的基礎

8-2 使用 Scrapy Shell

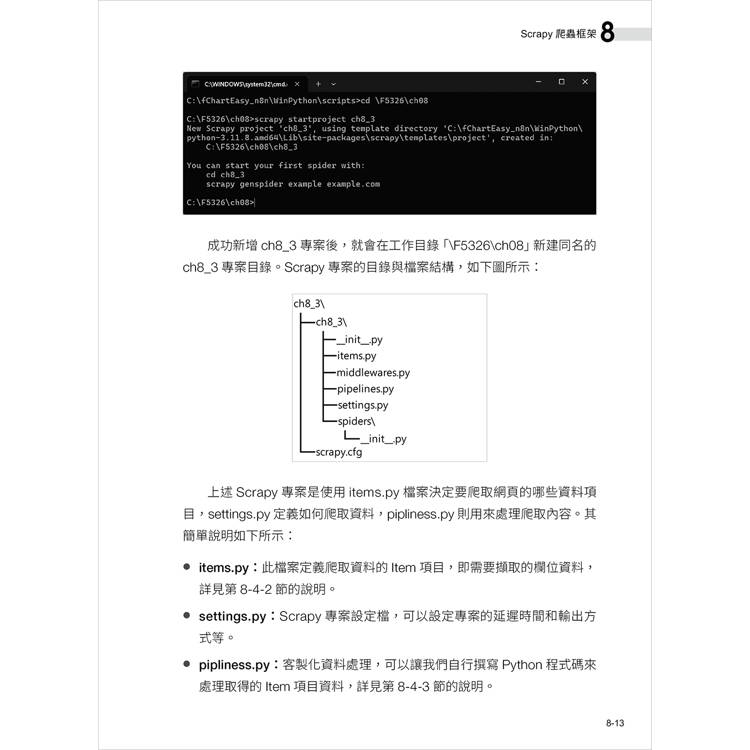

8-3 建立 Scrapy 專案的爬蟲程式

8-4 在專案使用 Item 和 Item Pipeline

8-5 輸出 Scrapy 爬取的資料

▌第 9 章 Python × ChatGPT 網路爬蟲

9-1 Python 爬蟲程式的常見問題

9-2 Requests + BeautifulSoup 爬蟲實作案例

9-3 Selenium 爬蟲實作案例

9-4 Scrapy 爬蟲實作案例

▌第 10 章 在 Python 使用 LLM 大型語言模型

10-1 認識生成式 AI 與 LLM

10-2 使用 OpenAI 的 ChatGPT API

10-3 使用 Google 的 Gemini API

10-4 LLM API 服務:Groq API

10-5 使用 Ollama 打造本機 LLM

▌第 11 章 Python × AI 網路爬蟲(一):非同步程式設計 + Crawl4AI

11-1 Python 非同步程式設計

11-2 Crawl4AI 的基本使用

11-3 內容篩選和客製化 Markdown 輸出

11-4 CSS 與 XPath 的 Schema 資料擷取

11-5 LLM 驅動的 AI 資料篩選與提取

11-6 深度爬取和 JavaScript 動態網頁處理

▌第 12 章 Python × AI 網路爬蟲(二):ScrapeGraphAI

12-1 ScrapeGraphAI 簡介與環境設定

12-2 基礎 Graph:SmartScraperGraph 與 SmartScraperMultiGraph

12-3 文字轉語音 Graph:SpeechGraph

12-4 腳本生成 Graph:ScriptCreatorGraph 與 ScriptCreatorMultiGraph

▌第 13 章 視覺化 AI 工作流程:n8n

13-1 認識 n8n 與工作流程

13-2 安裝與啟動 n8n 社群版

13-3 建立你的第 1 個工作流程

13-4 建立你的第 1 個 AI 工作流程

13-5 n8n 常用節點的使用

▌第 14 章 爬取知識庫的資料:SearXNG + Crawl4AI API

14-1 安裝、啟動與使用 Crawl4AI API

14-2 使用 SearXNG API

14-3 爬取 RAG 所需的知識庫資料

14-4 在 n8n 建立爬蟲程式和使用 SearXNG + Crawl4AI API

▌第 15 章 建立你自己的知識庫:Qdrant 向量資料庫

15-1 Embedding 模型:文字資料向量化

15-2 安裝與使用 Qdrant 向量資料庫

15-3 在 Python 程式使用 Qdrant 向量資料庫

15-4 建立你的知識庫:將文本內容存入向量資料庫

15-5 在 n8n 使用 Qdrant 向量資料庫

▌第 16 章 打造你自己的客製化 LLM:AI Agent、MCP 與 RAG 系統

16-1 認識 AI Assistant、RAG、AI Agent 和 MCP

16-2 使用 Python 手把手打造本機 RAG 系統

16-3 n8n 的 AI Agent 與 Tool

16-4 n8n 的 AI Agent 與 MCP

16-5 在 n8n 建立 RAG 的客製化 LLM

▌附錄 A Python 開發環境:Anaconda 與 WinPython 客製化套件(電子書)

A-1 建立 Anaconda 的 Python 開發環境

A-2 安裝本書客製化的 WinPython 可攜式套件

A-3 使用 Thonny 的 Python IDE

配送方式

-

台灣

- 國內宅配:本島、離島

-

到店取貨:

不限金額免運費

-

海外

- 國際快遞:全球

-

港澳店取:

訂購/退換貨須知

退換貨須知:

**提醒您,鑑賞期不等於試用期,退回商品須為全新狀態**

-

依據「消費者保護法」第19條及行政院消費者保護處公告之「通訊交易解除權合理例外情事適用準則」,以下商品購買後,除商品本身有瑕疵外,將不提供7天的猶豫期:

- 易於腐敗、保存期限較短或解約時即將逾期。(如:生鮮食品)

- 依消費者要求所為之客製化給付。(客製化商品)

- 報紙、期刊或雜誌。(含MOOK、外文雜誌)

- 經消費者拆封之影音商品或電腦軟體。

- 非以有形媒介提供之數位內容或一經提供即為完成之線上服務,經消費者事先同意始提供。(如:電子書、電子雜誌、下載版軟體、虛擬商品…等)

- 已拆封之個人衛生用品。(如:內衣褲、刮鬍刀、除毛刀…等)

- 若非上列種類商品,均享有到貨7天的猶豫期(含例假日)。

- 辦理退換貨時,商品(組合商品恕無法接受單獨退貨)必須是您收到商品時的原始狀態(包含商品本體、配件、贈品、保證書、所有附隨資料文件及原廠內外包裝…等),請勿直接使用原廠包裝寄送,或於原廠包裝上黏貼紙張或書寫文字。

- 退回商品若無法回復原狀,將請您負擔回復原狀所需費用,嚴重時將影響您的退貨權益。

商品評價